DeepMind社のリサーチャーJacob Menick 氏は「MLモデルはデータのViewでしかない」とつぶやかれています。

https://twitter.com/jacobmenick/status/1260658763687538688

これは実に真理をついていると思います。

MLモデルが y=f(x)のf と言えるならば、このf がデータのViewだと言ってるわけですね。

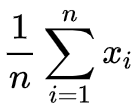

例えば、このf (x)を

としたらいかがでしょうか? そう相加平均。こんな単純な、と思ってもこれもデータ全体を表現したひとつのViewです。つまり入出力データをモデル化するということは、「入力データの、ある目的に沿った抽象化」ととらえられます。

予測モデルでは、ある未来予測という目的に沿ってログデータを活用した抽象化だといえます。ここで目的は暗に、x に対するy という形で与えられます。

元データにすべて入っている情報を料理するのが機械学習であり、それ以外に素材としては何も使っていないわけです。

となると、元データに目的を解くカギが過不足なく入っているのか? が問題となるわけです。そしてその意味では、画像認識はまさにこの条件を満たす理想のデータ(全ピクセルのRGB値)が対象であり、このことこそが深層学習が極限までワークする理由でもあります。音声認識も然り。

一方で、人の行動予測や株価の予測はどうでしょうか?

ここでは要素還元の限界を容易にみることができます。元データ特徴量にどこまで追加しても、ことの原因をすべて入れることはできません。複雑系に対して要素還元主義は無力です。

このように、深層学習が万能でないことが証明されました。